Spørsmål og svar

Data

For å se innholdet i ditt teams sine bøtter kan du enten gjøre dette med kode fra Jupyter, eller via Google Cloud Console (GCC). Les mer om hvordan man kan benytte GCC i SSB.

Husk at det er kun data-admins som skal kunne se innhold i kildeprosjektet til teamet. For å gjøre det må de aktivere en tilgang i JIT-applikasjonen.

Fremgangsmåten for gjenoppretting av filer er beskrevet i Backup-kapitlet.

I mars 2024 ble det gjort sikkerhetstiltak på Dapla som innebar at funksjonaliteten Download, Upload og Create folder i GCC ble skrudd av. Hvis man prøver å opprette en mappe på den måten vil man få en feilemelding som starter med

Request is prohibited by organization's policy. vpcServiceControlsUniqueIdentifier:

Hvis man skal opprette mapper i en bøtte så må man gjøre det med dapla-toolbelt, eller gjøre det fra en tjeneste som Jupyter i Dapla Lab. Sistnevnte metode betyr at man åpner tjenesten som det teamet og tilgangsgruppen som har tilgang til ønsket bøtte, og deretter kan man opprette mapper med mkdir i terminalen.

Datatjenester

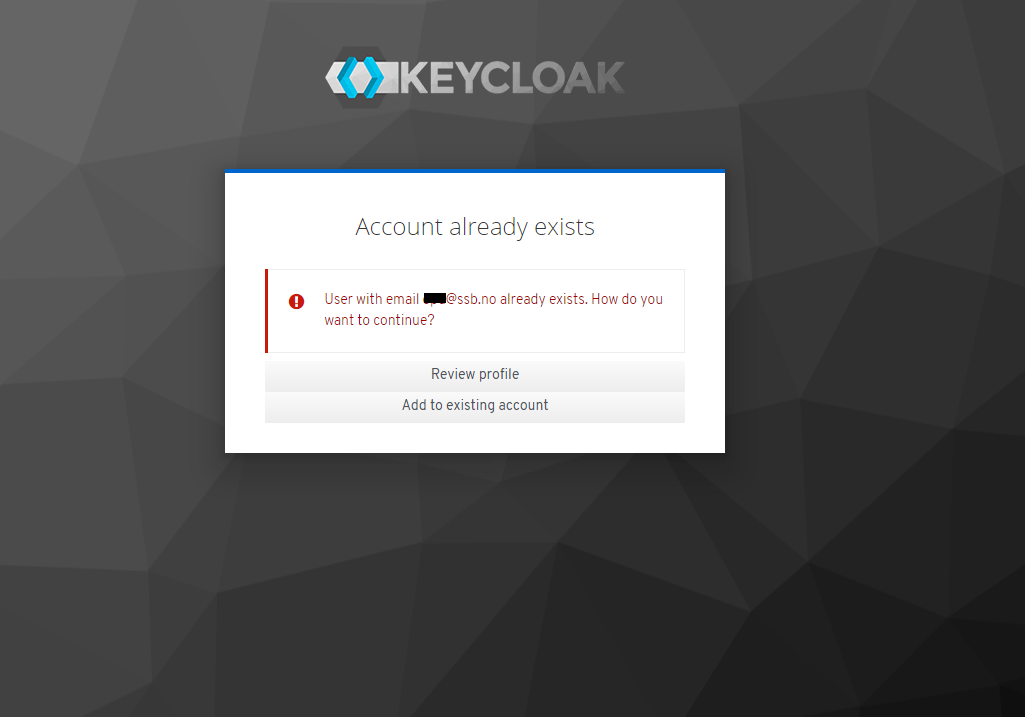

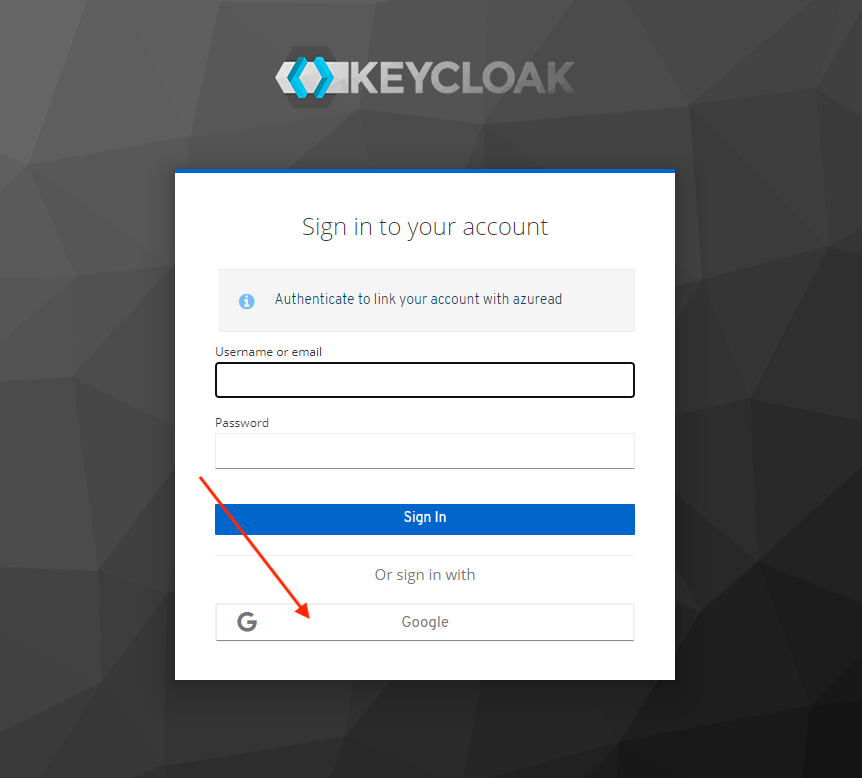

Det hender at man får melding om at Account already exists når man logger seg inn på en Dapla-tjeneste. For å løse dette gjør man følgende:

I Figur 2 skal du IKKE fylle inn Username or email og Password. Du skal kun trykke på Google-knappen.

Meldingen om at Account already exists forekommer svært sjelden, og typisk skjer det første gang man logger seg inn på en tjeneste.

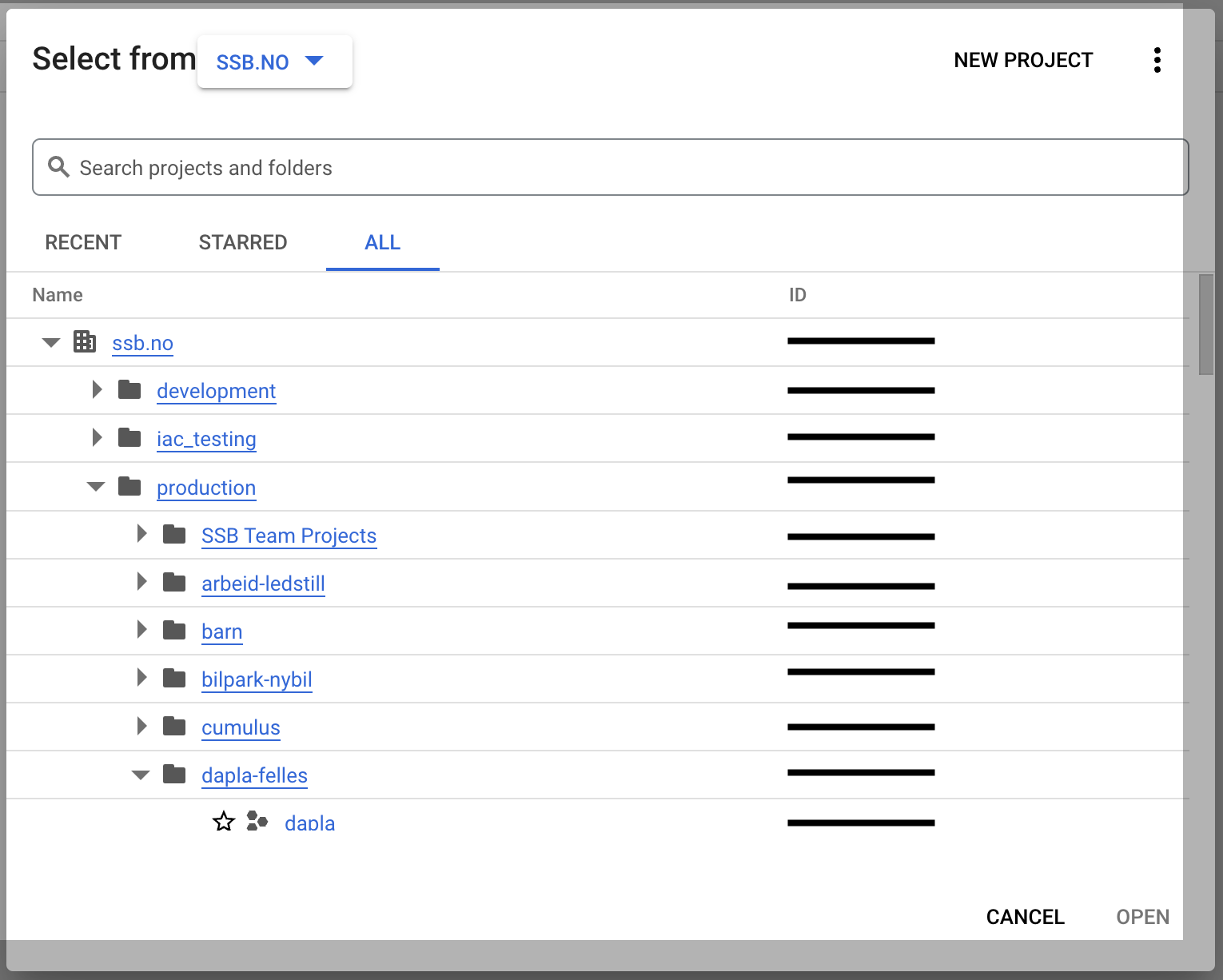

Prosjekt-ID-en til et Google-prosjekt er en unik identifikator som brukes til å identifisere prosjektet i Google Cloud Platform. Prosjekt-ID-en er en streng som består av små bokstaver, tall og bindestrek. Prosjekt-ID-en er ikke det samme som prosjektnavnet, som kan inneholde store bokstaver og mellomrom.

Du finner prosjekt-ID ved logge deg inn på GCC, åpne prosjektvelgeren, søk opp ditt prosjekt, og så ser du det i høyre kolonne, slik som vist i denne sladdete kolonnen i Figur 3.

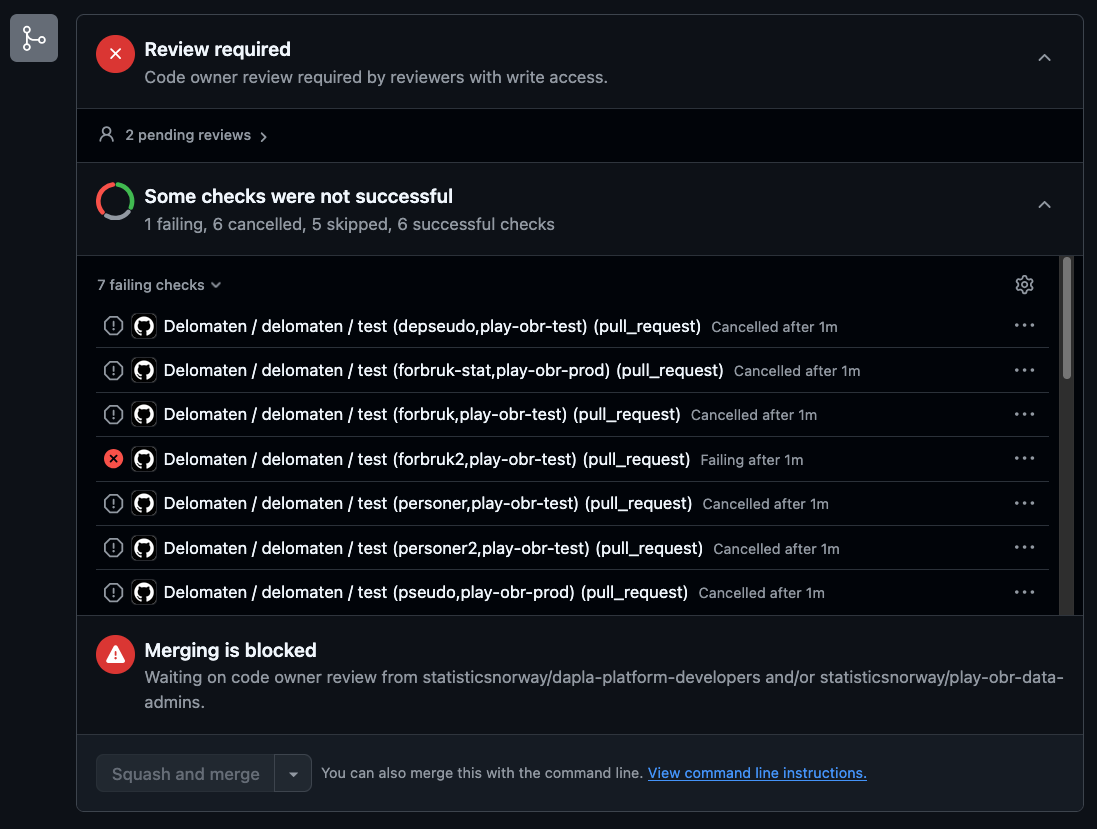

Hvis man får feilmeldinger ved utrulling av Delomat-jobber, så bør man først undersøke hva feilmeldingen sier. Den gir ofte nyttige tilbakemelding om det er gjort noen formelle feil. Hvis dette ikke fører frem, så kan man ta kontakt med Kundeservice for hjelp.

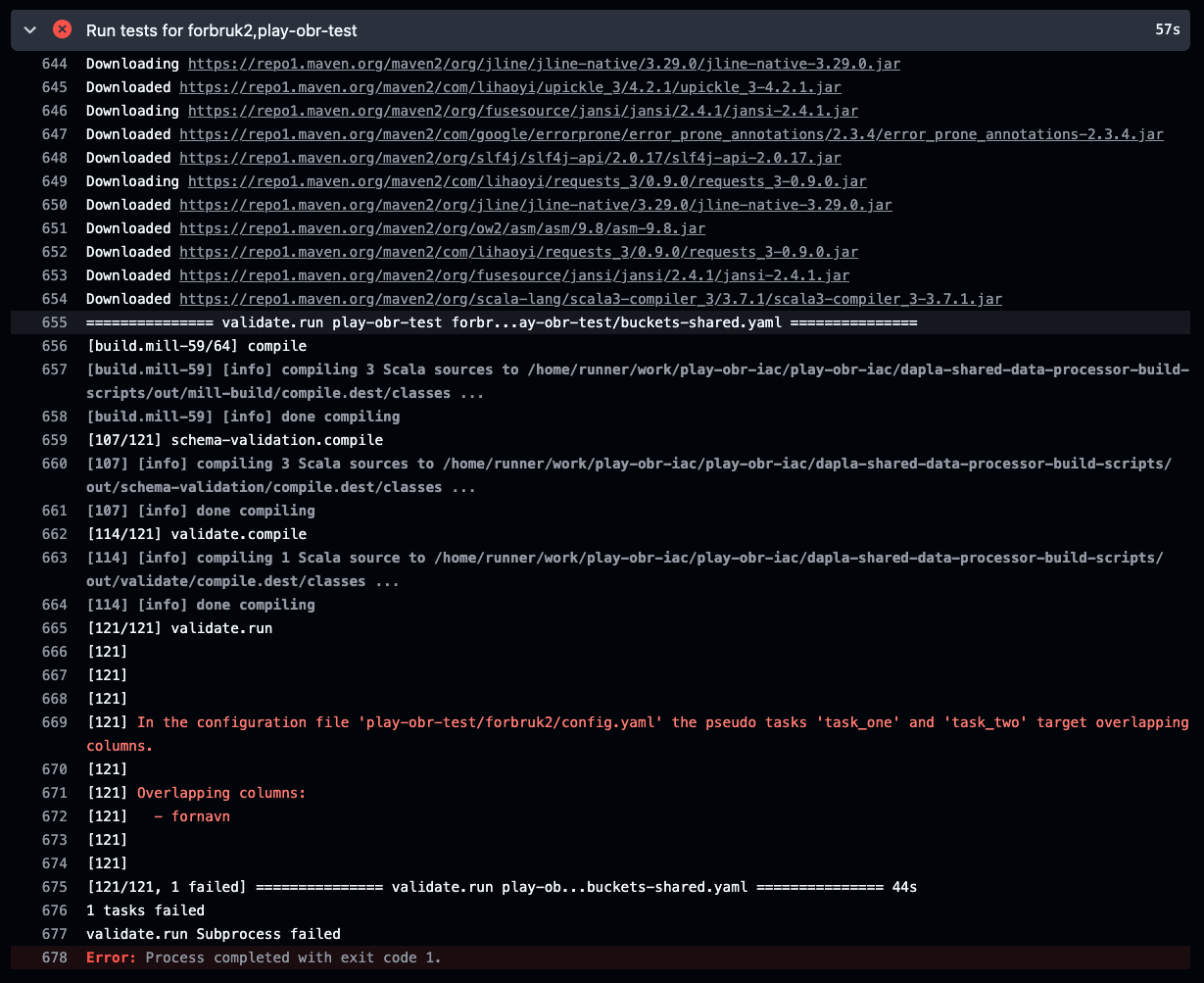

Konfigurasjonsfilen valideres automatisk når du oppretter en pull request i GitHub. Hvis noe er feil får du en feilmelding:

Eksempel på feilmelding i workflow

En delt-bøtte kan kun slettes hvis den er helt tom for data. Det betyr at:

- Alle filer og mapper må være slettet.

- Siden filer versjoneres i delt-bøtter må også alle gamle versjoner av filer også være slettet (såkalt non-current objekter).

Hvis man har prøvd å slette en delt-bøtte ved fjerne bøtten fra shared-buckets.yaml, kjøre atlantis apply og deretter fått feilmeldingen Error trying to delete bucket <bøttenavn> objects without 'force destroy' set to true, så betyr det at det fortsatt ligger data i bøtta. Da kan du gjøre følgende for å få slettet bøtta:

Legg til delt-bøtta i buckets-shared.yaml igjen og kjør

atlantis applyetter å ha fått godkjenning.Kjør følgende Python-script i en tjeneste på Dapla Lab som er startet med teamets developers-gruppe og

google-cloud-storageer installert:

Notebook

- Fjern delt-bøtta fra buckets-shared.yaml igjen og kjør

atlantis applyetter godkjenning.

Fungerer ikke det så kan man ta kontakt med Kundeservice og få hjelp.

Du kan sjekke om teamet ditt har tilgang til Kildomaten ved å gå inn i teamets IaC-repo. Du finner IaC-repoet ved å søke etter team-navnet på statisticsnorway på Github. Repoet er det som heter <teamnavn>-iac. Inne i repoet går du inn filen infra/projects.yaml.

I eksemplet til høyre ser vi hvordan filen ser ut for det fiktive teamet dapla-example. For dette teamet ser vi at Kildomaten er skrudd på i prod-miljøet til teamet, men ikke test-miljøet.

Når man skrur på en feature på Dapla, så er det verktøyet Atlantis som ruller ut infrastrukturen på GCP. I mange tilfeller kan det hjelpe å skrive atlantis plan i kommentarfeltet til PR’en, slik at Atlantis får kjørt planen en gang til. Hvis den da ikke viser noen feil, så kan du skrive atlantis apply i kommentarfeltet og endringene vil bli effektuert. Får du fortsatt feilmeldinger etter å ha kjørt atlantis plan på nytt, så bør du kontakte Kundeservice for hjelp.

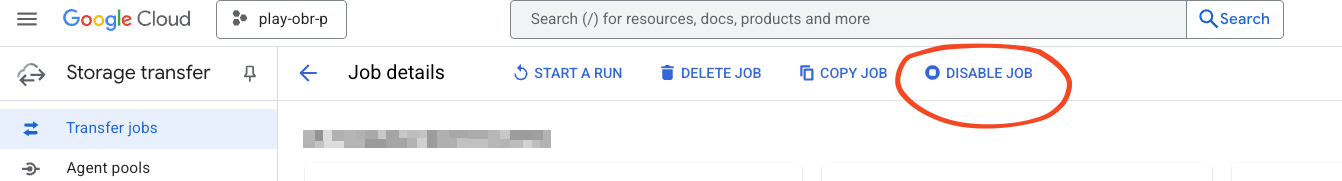

Man kan pause en regelmessig jobb med Transfer Service fra Google Cloud Console i nettleseren.

- Søk opp Transfer Jobs i søkefeltet øverst på siden.

- Velg hvilken Transfer Service jobb som skal endres.

- Velg Disable job som vist i Figur 5

For å aktivere jobben kan man følge stegene over, men da velge Enable job i siste steg.

Dapla Lab

Her finner du Dokumentasjonen for Dapla Lab.

Dokumentasjon for tjenestene finner du i Dapla-manualen under Datatjenester/Dapla Lab tjenester.

I de fleste tilfeller vil dette løses seg ved at laster inn siden på nytt eller refresher siden.

Grunnen til at det skjer er at Dapla Lab bare er tilgjengelig for de som er logget på SSBs nettverk. Hvis du forlater maskinen med Dapla Lab åpnet i nettleseren over lang tid, så kan det være at du har falt ut av SSBs nettverk og Dapla Lab ikke oppdager at du er logget inn igjen.

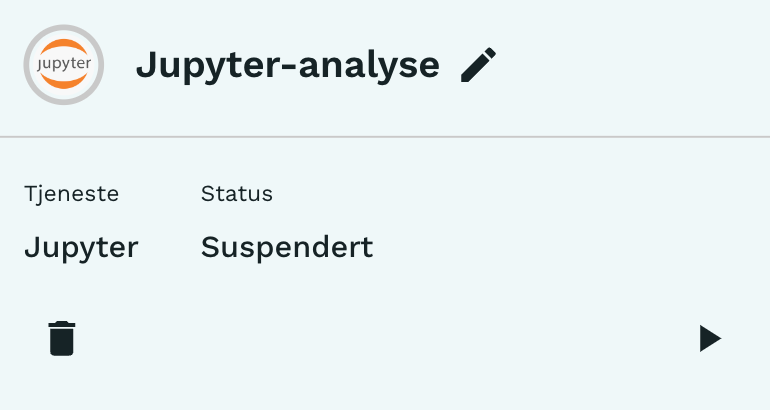

At en tjeneste er suspendert betyr at tjenesten er satt på pause. I praksis vil det si at ressursene, f.eks. CPU og RAM, som tjenesten har reservert har blitt frigjort. Man kan starte tjenesten på nytt ved å trykke på Play-knappen i bildet til høyre, og man starter opp tjenesten på nytt med de samme ressursene. Alt som ble lagret i tjenestens lokale filsystem under /home/onyxia/work/blir også gjennopprettet, mens resten blir borte. Derfor bør alltid kode lagres under work-mappen.

Hvis man opplever at en tjeneste fortsatt pauses selv om man har endret visningsnavnet til tjenesten til å inkludere [nosuspend], så kan det skyldes at man faktisk ikke har lagret det nye navnet. For å lagre det nye navnet så må man trykke Enter etter at man skrevet inn [nosuspend]. Gjør man ikke dette kan det tilsynelatende virke som om du har endret navnet selv om det ikke lagret. Du kan verifisere at navnet er riktig ved refreshe siden og se at navnet nå er riktig.

Ja. Medlemmer av gruppen data-admins kan gi seg selv midlertidig tilgang til kildedata. Dette gjøres ved å bruke Just-in-Time Access (JIT) applikasjonen: https://jitaccess.dapla.ssb.no. Les manual-artikkelen om JIT for en veiledning.

Mange ansatte i SSB er med i flere Dapla-team, og hvert av brukernes teammedlemskap gir ofte tilgang til data iht til formaålet for teamet. hver av teamene har tilgang til sine data og potensielt andres delt data. For å unngå for brede tilganger til data så innfører vi at en bruker må bestemme seg for hvilket team og tilgangsgruppe de skal representere før de starter arbeid med data i et programmeringsmiljø. Dette gjør at vi kan være sikker på at ingen kan koble data på tvers av team.

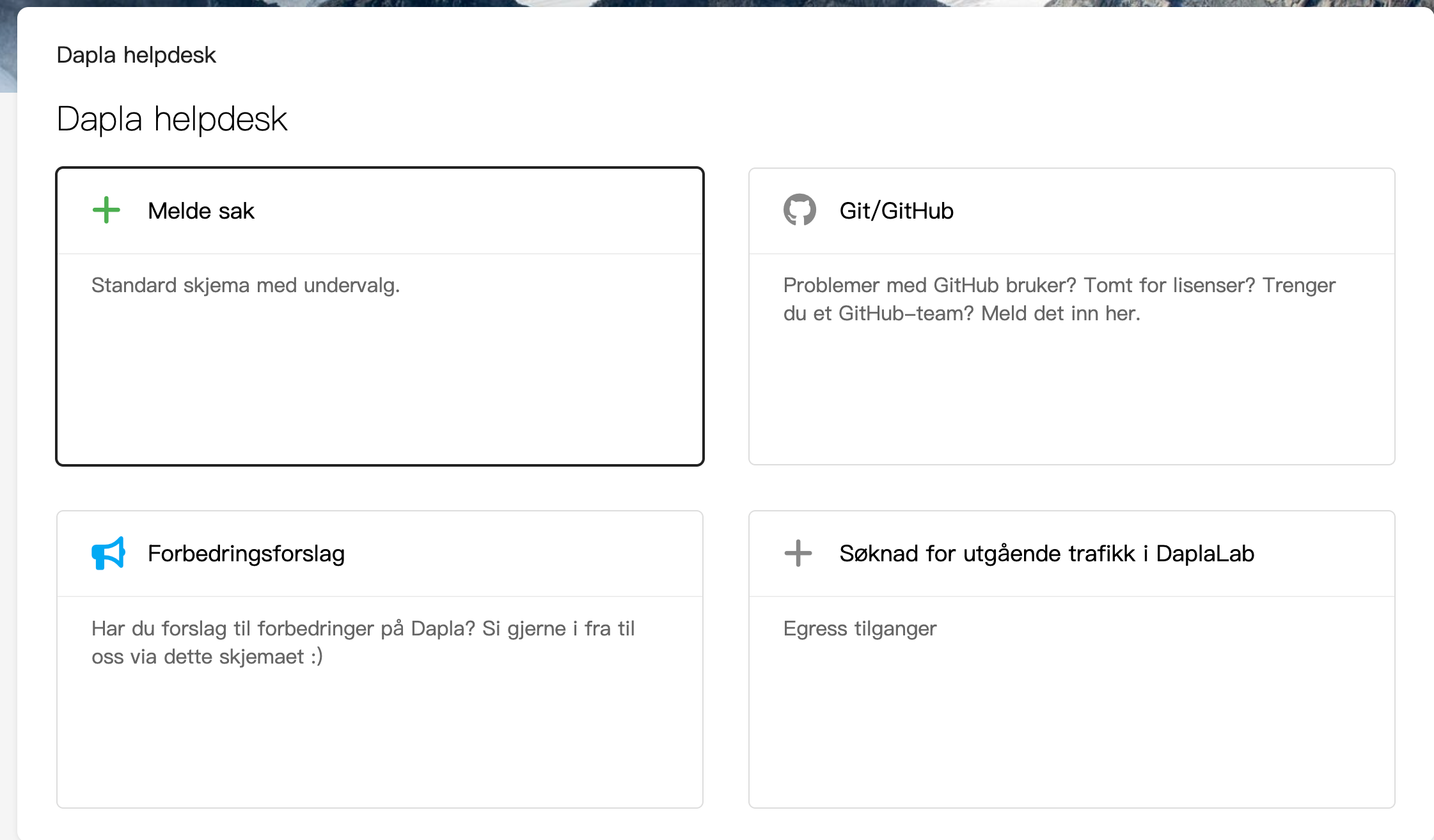

Hvis du trenger å hente data fra eksterne kilder til bruk i statistikkproduksjonen (f.eks. APIer), må du søke om tilgang til dette hos Team M2M. Dette gjøres ved å melde sak til Kundeservice. Se veiledning nedenfor.

Fra Byrånettet velg Arbeidsverktøy og Meld sak til kundeservice. Logg deg inn ved å velge Logg inn med federert autentisering. Inne løsningen velger du deretter Dapla helpdesk. Figur 6 viser menyen som vises.

Fra menyen velger du Søknad for utgående trafikk i DaplaLab, fyller ut skjemaet som vises og trykker på «Send».

Team M2M vil så godkjenne eller avslå søknaden. Hvis søknaden godkjennes sendes saken videre til Kundeservice for effektuering. Hvis avslag så får du en begrunnelse for dette fra Team M2M.

Dette er miljøvariablene som alltid vil være tilgjengelig i Jupyterlab, Rstudio og VSCode:

| Miljøvariabel | Forklaring |

|---|---|

| DAPLA_ENVIRONMENT | Hvilket dapla-lab miljø du kjører i f.eks PROD, TEST eller DEV |

| DAPLA_REGION | Hvilket dapla miljø du kjører i f.eks. DAPLA_LAB eller BIP |

| DAPLA_USER | Epostaddressen til den innloggede brukeren f.eks. obr@ssb.no |

| DAPLA_SERVICE | Dapla tjenesten som er i bruk f.eks. JUPYTERLAB eller VS_CODE |

| STAT_TEMPLATE_DEFAULT_REFERENCE | Hvilken versjon av ssb-project templatet som skal brukes f.eks. 1.1.8 |

| PSEUDO_SERVICE_URL | URL til pseudotjenesten for bruk til testing |

| STATBANK_BASE_URL | URL til statistikkbanken |

| STATBANK_ENCRYPT_URL | URL til ‘statbank-authenticator’ sitt krypteringsendepunkt |

| STATBANK_TEST_BASE_URL | URL til statistikkbanken (i test) |

| STATBANK_TEST_ENCRYPT_URL | URL til ‘statbank-authenticator (i test)’ sitt krypteringsendepunkt |

Når du mottar følgende melding i Jupyter:

Feilmelding:

IOPub data rate exceeded. The Jupyter server will temporarily stop sending output to the client in order to avoid crashing it. To change this limit, set the config variable `--ServerApp.iopub_data_rate_limit`. Current values: ServerApp.iopub_data_rate_limit=1000000.0 (bytes/sec) ServerApp.rate_limit_window=3.0 (secs)

betyr det at mengden data som sendes fra jupyter-kernelen til jupyterlab-frontend overskrider den tillatte grensen. Selv om det er mulig å justere ServerApp.iopub_data_rate_limit og ServerApp.rate_limit_window for å endre denne grensen, ønsker vi ikke dette. Å endre disse verdiene kan ha en negativ påvirkning på Jupyterlab sin ytelse.

Her er noen løsningsforslag:

- Reduser datamengden: Prøv å redusere datamengden du prøver å vise. Hvis du for eksempel viser en stor pandas dataframe, kan du vise kun toppradene med

df.head()eller et tilfeldig utvalg meddf.sample(10). - Legg til forsinkelse: Bruk

time.sleep()-funksjonen i Python for å legge til en pause mellom hver utskrift. Dette kan spre utdataene over en lengre tidsperiode, noe som kan hjelpe med å unngå å overskride datagrensen. - Skriv til en fil: I stedet for å skrive utdata direkte i Jupyter, kan du vurdere å skrive dataene til en fil. Dette omgår IOPub-datahastighetsgrensen, og du kan se gjennom dataene i ettertid.

- Unngå utskrift: Hvis du kun trenger å utføre beregninger eller operasjoner på dataene, vurder å gjøre det uten å skrive ut resultatene i Jupyter.

For å jobbe med notebooks i VS Code kan du gjøre følgende:

- Åpne en ny Vscode-python

- Åpne en terminal under File/Terminal/New terminal

- Opprett et ssb-project som vanlig under mappen

/home/onyxia/work/ved å skrivessb-project create <prosjektnavn>.- Dersom du allerede har et ssb-project, skriver du

cd <prosjektnavn>etterfulgt avssb-project build. Da blir prosjektets tilhørende pakker installert i en kernel med samme navn som prosjektet.

- Dersom du allerede har et ssb-project, skriver du

- Gå inn i mappen med

cd <prosjektnavn> - Installer ønskede pakker

poetry add pandas, f.eks. Pandas. - Velg prosjektmappen i filutforskeren ved å gå til File/Open folder/ og åpne prosjektmappen i boksen som vises.

- Opprett en notebook-fil og åpne den.

- Trykk Refresh på hele nettsiden for å få opp visningen av den nyopprettede kernels.

- Øverst til høyre i Notebooken kan du trykke på Select kernel og utforskeren velger du Jupyter kernels og deretter den som har samme navn som prosjektet ditt.

- Til slutt kan du teste at riktig Python-installasjon er valgt ved å importere pakken du akkurat installerte.

Du må kjøre en ssb-project build, som beskrevet over, hver gang en instans av Jupyter, eller VSCode blir startet. Hvis du isteden åpner en pauset (suspendert) instans, vil du kunne fortsette arbeidet fra forrige kjøring uten å måtte kjøre ssb-project build.

Fra vscode-python tjenesten

Det fungerer best å kjøre Dash-apper i en egen fane i nettleseren. Inline-visning av figurer fungerer ikke enda.

Her er et eksempel på hvordan man lager en Dash-app i DaplaLab i en vscode tjeneste:

- Installer

pandasogdashi et ssb-project. - Opprett et python-script i prosjektet som f.eks. heter

app.py. - Kjør scriptet ved å kjøre følgende kommando fra terminalen:

poetry run python ./app.py - Deretter kommer det opp et dialog-vinduet hvor du velger

Open in browser.

Her er et eksempel på script som fungerer i Vscode-python:

app.py

from dash import Dash, html, dcc, callback, Output, Input

import plotly.express as px

import pandas as pd

# Creating a sample dataset similar to the Gapminder dataset

data = {

'country': ['Afghanistan', 'Afghanistan', 'Afghanistan', 'Brazil', 'Brazil', 'Brazil', 'China', 'China', 'China'],

'continent': ['Asia', 'Asia', 'Asia', 'South America', 'South America', 'South America', 'Asia', 'Asia', 'Asia'],

'year': [1952, 1977, 2007, 1952, 1977, 2007, 1952, 1977, 2007],

'lifeExp': [28.801, 39.877, 43.828, 50.917, 59.504, 72.390, 44.000, 63.739, 72.961],

'pop': [8425333, 12412311, 31889923, 56602560, 80461570, 190010647, 556263527, 862030000, 1318683096],

'gdpPercap': [779.4453145, 786.11336, 974.5803384, 2108.944355, 5718.766744, 9065.800825, 400.448611, 1488.041713, 4959.114854]

}

# Creating DataFrame

df = pd.DataFrame(data)

# Creating the app

app = Dash(

__name__,

requests_pathname_prefix='/proxy/8050/',

serve_locally=True

)

app.layout = [

html.H1(children='Title of Dash App', style={'textAlign':'center'}),

dcc.Dropdown(df.country.unique(), 'Canada', id='dropdown-selection'),

dcc.Graph(id='graph-content')

]

@callback(

Output('graph-content', 'figure'),

Input('dropdown-selection', 'value')

)

def update_graph(value):

dff = df[df.country==value]

return px.line(dff, x='year', y='pop')

if __name__ == '__main__':

app.run(debug=True)Fra jupyter tjenesten

Det fungerer best å kjøre Dash-apper i en egen fane i nettleseren, men inline-visning skal også være mulig i notebook.

Her er et eksempel på hvordan man lager en Dash-app i DaplaLab i en jupyter tjeneste:

- Installer

pandasogdashi et ssb-project. - Opprett en notebook i prosjektet som f.eks. heter

app.ipynb.

Her er et eksempel på kode som fungerer i jupyter:

app.ipynb

# %%

# Notebook cell 1

from dash import Dash, html, dcc, callback, Output, Input

import plotly.express as px

import pandas as pd

# %%

# Notebook cell 2

# Creating a sample dataset similar to the Gapminder dataset

data = {

'country': ['Afghanistan', 'Afghanistan', 'Afghanistan', 'Brazil', 'Brazil', 'Brazil', 'China', 'China', 'China'],

'continent': ['Asia', 'Asia', 'Asia', 'South America', 'South America', 'South America', 'Asia', 'Asia', 'Asia'],

'year': [1952, 1977, 2007, 1952, 1977, 2007, 1952, 1977, 2007],

'lifeExp': [28.801, 39.877, 43.828, 50.917, 59.504, 72.390, 44.000, 63.739, 72.961],

'pop': [8425333, 12412311, 31889923, 56602560, 80461570, 190010647, 556263527, 862030000, 1318683096],

'gdpPercap': [779.4453145, 786.11336, 974.5803384, 2108.944355, 5718.766744, 9065.800825, 400.448611, 1488.041713, 4959.114854]

}

# Creating DataFrame

df = pd.DataFrame(data)

# Creating the app

port = 8050 # must be between 1024 and 9999

service_prefix = os.getenv('JUPYTERHUB_SERVICE_PREFIX', '/')

domain = os.getenv('JUPYTERHUB_HTTP_REFERER', None)

app = Dash(

__name__,

requests_pathname_prefix=f"{service_prefix}proxy/{port}/",

serve_locally=True

)

app.layout = [

html.H1(children='Title of Dash App', style={'textAlign':'center'}),

dcc.Dropdown(df.country.unique(), 'Canada', id='dropdown-selection'),

dcc.Graph(id='graph-content')

]

@callback(

Output('graph-content', 'figure'),

Input('dropdown-selection', 'value')

)

def update_graph(value):

dff = df[df.country==value]

return px.line(dff, x='year', y='pop')

if __name__ == '__main__':

# For jupyter_mode, choose between 'external' or 'inline'.

# 'jupyterlab' should also be poosible, but doesn't seem to work...

app.run(jupyter_mode="external", jupyter_server_url=domain, port=port)Lagrede tjenestekonfigurasjoner er kun lagret lokalt i brukerens nettleser. Hvis du akkurat har slettet nettleserens nettlesingsdata (historikk, logg, etc.) vil også lagrede tjenestekonfigurasjoner slettes. Det samme er tilfellet hvis man tar i bruk en ny nettleser.

Git og GitHub

Hovedregelen er at vi arkiverer repoer istedenfor å slette. Det skyldes at vi kan trenge å ettergå historikken i repoer ved et senere tidspunkt. Arkivering av repoer kan du gjøre selv under Settings i repoet.

I de tilfellene der du mener at det gir mest mening å slette repoet, så må dette gjøres av en Github-administrator. Da sender du en henvendelse til Kundeservice og ber om at repoet slettes. Husk å oppgi navnet på repoet du ønsker å få slettet.

git status endringer når jeg ikke har endret filene?

Dette kan noen ganger forekomme med notebooks eller ipynb-filer fordi de inneholder metadata som kan bli endret over tid. Siden ipynb-filer er et json-basert format, som inkluderer metadata som oppdaterer seg i bakgrunnen, så kan en endring i strukturen til metadataene føre til endringer i den underliggende json-fila selv om man ikke har gjort endringer i ipynb-fila. Endringene blir deretter plukket opp av git som følger med på endringer i filene.

En mulig løsning er å sjekke inn endringene i kodebasen.

I noen tilfeller viser git status at det har skjedd endringer i filer, men git diff viser ingen endring. I disse tilfellene kan det være ulike problemer i bakgrunnen. Se denne oversikten over problemer og tilhørende løsninger.

Første gang man begynner å jobbe med kode i SSBs GitHub-organisasjon statisticsnorway, så følger man denne oppskriften fra Dapla-manualen. Men hvis man bytter telefon eller lignende, så må man sette opp dette på nytt.

Prosessen for å bytte 2FA-metode for autentisering er beskrevet i GitHub sin dokumentasjon. Gjør følgende:

- Logg deg inn med din bruker på https://github.com/.

- Klikk på din profil, øverst til høyre på siden, og velg Settings

- I menyen til venstre velger du Password and authentication

- Skroll ned til Two-factor-authentication

- Under Two-factor-methods vil du se Authenticator app (Configured) hvis du har brukt dette tidligere.

- Trykk Edit

- Skann QR-koden som dukker opp med Authenticator-appen på din nye mobil.

- Følg instruksjonene og lagre autentiseringsmetoden når du er ferdig.

Når du oppretter et GitHub-repository, blir din bruker automatisk satt som admin på repositoryet. For at flere personer skal få tilgang, må du selv legge dem til i GitHub.

Legge til et helt team (anbefalt)

Hvis du jobber i et team, anbefales det å gi tilgang via et GitHub-team. Da slipper du å administrere enkeltbrukere én og én.

- Gå til repositoryet på GitHub

- Velg Settings

- Gå til Collaborators and teams

- Under Teams, søk opp og legg til ønsket team

- Velg riktig tilgangsnivå (for eksempel

Read,WriteellerAdmin)

Alle medlemmene i teamet vil da få tilgang til repositoryet.

Legge til enkeltbrukere

Hvis du kun skal gi tilgang til én personer:

- Gå til repositoryet på GitHub

- Velg Settings

- Gå til Collaborators and teams

- Under Collaborators, legg til GitHub-brukernavnet til personen

- Velg ønsket tilgangsnivå